Quản lý kho hàng hiệu quả là yếu tố sống còn đối với bất kỳ…

Cách di chuyển kho dữ liệu on premises sang BigQuery trên Google Cloud

Nhóm Dữ liệu của các công ty luôn gặp phải những thách thức liên tục trong việc hợp nhất, xử lý và làm cho dữ liệu trở nên hữu ích. Họ đối phó với những thách thức như hỗn hợp nhiều công việc ETL, kho dữ liệu on premises có giới hạn dung lượng ETL dài và nhu cầu ngày càng tăng từ người dùng. Họ cũng cần đảm bảo rằng các yêu cầu hạ nguồn của ML, báo cáo và phân tích được đáp ứng với quá trình xử lý dữ liệu. Và họ cần lập kế hoạch cho tương lai – nhiều dữ liệu hơn sẽ được xử lý như thế nào và các nhóm hạ nguồn mới sẽ được hỗ trợ như thế nào?

> Tham khảo:

- Phân tích khối dữ liệu lớn với BigQuery và Google Sheets

- Giới thiệu Datastream cho Google BigQuery

- Tối ưu BigQuery với nguồn dữ liệu trong Google Cloud VMware Engine

Tại sao sử dụng BigQuery?

Các kho dữ liệu on premises trở nên khó mở rộng quy mô vì vậy mục tiêu lớn nhất của hầu hết các công ty là tạo ra một hệ thống trong tương lai để lưu trữ dữ liệu an toàn, có thể mở rộng và hiệu quả về chi phí. BigQuery của GCP không có máy chủ, có khả năng mở rộng cao và tiết kiệm chi phí và là một kỹ thuật phù hợp tuyệt vời cho trường hợp sử dụng EDW. Đó là một kho dữ liệu nhiều đám mây được thiết kế cho sự nhanh nhạy trong kinh doanh. Tuy nhiên, việc di chuyển một kho dữ liệu lớn, được tích hợp cao từ kho dữ liệu on premise sang BigQuery không phải là chuyển đổi đơn giản. Bạn cần đảm bảo rằng hệ thống hạ nguồn của bạn không bị hỏng do kết quả không nhất quán trong việc di chuyển tập dữ liệu, cả trong và sau khi di chuyển. Vì vậy, bạn phải lập kế hoạch di chuyển của mình.

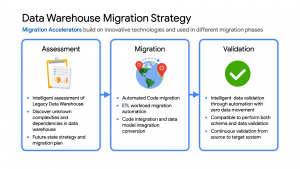

Chiến lược di chuyển kho dữ liệu

Các bước sau đây là điển hình để di chuyển thành công:

-

- Đánh giá và lập kế hoạch: Tìm trước phạm vi để lập kế hoạch di chuyển kho dữ liệu kế thừa

- Xác định các nhóm dữ liệu, các mẫu và khả năng truy cập ứng dụng

- Sử dụng các công cụ và tiện ích để xác định các mức độ phức tạp và các phụ thuộc chưa biết

- Xác định chuyển đổi ứng dụng cần thiết và thử nghiệm

- Xác định khả năng xử lý và lưu trữ ban đầu để dự báo ngân sách và lập kế hoạch năng lực

- Xem xét tăng trưởng và những thay đổi được dự đoán trong giai đoạn di chuyển

- Xây dựng chiến lược trạng thái trong tương lai và tầm nhìn để hướng dẫn thiết kế

- Di chuyển: Thiết lập nền tảng GCP và bắt đầu di chuyển

- Nền tảng đám mây đang được thiết lập, hãy cân nhắc việc chạy các POC tập trung để xác thực các quy trình và tiến trình di chuyển dữ liệu

- Tìm kiếm các tiện ích tự động để trợ giúp với bất kỳ quá trình di chuyển code bắt buộc nào

- Kế hoạch duy trì đồng bộ hóa dữ liệu giữa EDW kế thừa và mục tiêu trong suốt thời gian di chuyển. Đây trở thành một quy trình kinh doanh quan trọng để giữ cho dự án đúng tiến độ.

- Lên kế hoạch tích hợp một số công cụ dành cho doanh nghiệp để giúp các nhóm hiện có mở rộng cả hai môi trường

- Xem xét các mẫu truy cập dữ liệu hiện tại giữa các cộng đồng người dùng EDW và cách họ ánh xạ tới các điều khiển tương tự có sẵn trong Big Query.

- Phạm vi chính bao gồm tích hợp code và chuyển đổi mô hình dữ liệu

- Mong đợi để tinh chỉnh dự báo năng lực và tinh chỉnh thiết kế phân bổ. Trong Big Query, có nhiều tùy chọn để cân bằng giữa chi phí và hiệu suất nhằm tối đa hóa giá trị kinh doanh. Ví dụ: bạn có thể sử dụng theo yêu cầu hoặc giá cố định hoặc kết hợp cả hai.

- Đánh giá và lập kế hoạch: Tìm trước phạm vi để lập kế hoạch di chuyển kho dữ liệu kế thừa

- Xác thực và kiểm tra

-

- Tìm kiếm các công cụ để cho phép xác thực dữ liệu tự động, thông minh

- Phạm vi phải bao gồm cả schema và xác thực dữ liệu

- Lý tưởng nhất là các giải pháp sẽ cho phép xác nhận liên tục từ nguồn đến hệ thống đích trong quá trình di chuyển

- Độ phức tạp và thời lượng kiểm tra sẽ được thúc đẩy bởi số lượng và độ phức tạp của các ứng dụng sử dụng dữ liệu từ EDW và tỷ lệ thay đổi của các ứng dụng đó

Chìa khóa để di chuyển thành công là tìm kiếm các đối tác của Google Cloud có kinh nghiệm di chuyển khối lượng công việc EDW. Ví dụ: đối tác của Google Cloud của chúng tôi Datametica cung cấp các dịch vụ và Trình tăng tốc di chuyển chuyên biệt cho từng giai đoạn di chuyển này để giúp lập kế hoạch và thực hiện di chuyển hiệu quả hơn

Di chuyển kho dữ liệu: Những điều cần xem xét

- Lợi ích tài chính của nguồn mở: Mục tiêu chuyển sang ‘Nguồn mở’ nơi không có dịch vụ nào có phí giấy phép. Ví dụ: BigQuery sử dụng SQL chuẩn; Cloud Composer được quản lý bởi Apache Airflow, Dataflow dựa trên Apache Beam. Việc coi đây là các dịch vụ được quản lý mang lại lợi ích tài chính của nguồn mở, nhưng tránh gánh nặng duy trì các nền tảng nguồn mở trong nội bộ.

- Serverless: Di chuyển đến các dịch vụ dữ liệu lớn “serverless”. Phần lớn các dịch vụ được sử dụng trong quy mô kiến trúc dữ liệu GCP được đề xuất theo yêu cầu cho phép điều chỉnh chi phí hiệu quả hơn với nhu cầu. Sử dụng các dịch vụ được quản lý hoàn toàn cho phép bạn tập trung thời gian kỹ thuật vào các ưu tiên của quá trình kinh doanh, không phải xây dựng và duy trì cơ sở hạ tầng.

- Hiệu quả của một nền tảng hợp nhất: Bất kỳ quá trình di chuyển kho dữ liệu nào cũng liên quan đến việc tích hợp với các dịch vụ xung quanh EDW để nhập và xử lý trước dữ liệu và phân tích nâng cao trên dữ liệu được lưu trữ trong EDW để tối đa hóa giá trị kinh doanh. Một nhà cung cấp đám mây như GCP cung cấp toàn bộ các dịch vụ ‘dữ liệu lớn’ được tích hợp và quản lý bằng tích hợp machine learning. Điều này có thể làm giảm đáng kể TCO dài hạn bằng cách tăng cả hiệu quả hoạt động và chi phí khi so sánh với các giải pháp điểm cụ thể EDW.

- Thiết lập nền tảng đám mây vững chắc: Ngay từ đầu, hãy dành thời gian để thiết kế một nền tảng an toàn sẽ phục vụ nhu cầu kinh doanh và kỹ thuật cho khối lượng công việc tiếp theo. Các tính năng chính bao gồm: Hệ thống phân cấp tài nguyên có thể mở rộng, Bảo mật nhiều lớp, mạng nhiều tầng và chiến lược trung tâm dữ liệu và tự động hóa bằng cách sử dụng Cơ sở hạ tầng dưới dạng code. Đồng thời cho phép thời gian tích hợp các dịch vụ dựa trên đám mây vào các hệ thống doanh nghiệp hiện có như đường ống CI / CD, giám sát, cảnh báo, ghi nhật ký, lập lịch quy trình và quản lý yêu cầu dịch vụ.

- Dung lượng mở rộng không giới hạn: Chuyển sang đám mây nghe có vẻ là một bước tiến lớn, nhưng hãy thực sự coi đây là việc bổ sung thêm nhiều trung tâm dữ liệu hơn cho các nhóm của bạn. Tất nhiên, các trung tâm dữ liệu này cung cấp nhiều dịch vụ mới rất khó phát triển nội bộ và cung cấp khả năng mở rộng gần như không giới hạn với cam kết tài chính trả trước tối thiểu. .

- Nền tảng kiên nhẫn và tạm thời: Di chuyển EDW thường là một dự án chạy dài. Sẵn sàng thiết kế và vận hành các nền tảng tạm thời để đồng bộ hóa dữ liệu, xác nhận và thử nghiệm ứng dụng. Xem xét tác động đối với hệ thống lên và xuống. Sẽ có ý nghĩa nếu di chuyển và hiện đại hóa các hệ thống này đồng thời với quá trình di chuyển EDW vì chúng có thể là nguồn dữ liệu và phần chìm và có thể đang đối mặt với những thách thức tăng trưởng tương tự. Cũng sẵn sàng đáp ứng các yêu cầu kinh doanh mới phát triển trong quá trình di chuyển. Hãy tận dụng khoảng thời gian dài để các nhóm hoạt động hiện tại của bạn học các dịch vụ mới từ đối tác dẫn đầu việc triển khai để các nhóm của bạn sẵn sàng tiếp quản sau khi di chuyển.

- Đối tác có kinh nghiệm: Di chuyển EDW có thể là một công việc lớn với những thách thức và rủi ro trong quá trình di chuyển, nhưng mang lại cơ hội to lớn để giảm chi phí, đơn giản hóa hoạt động và cung cấp năng lực cải thiện đáng kể cho người dùng EDW bên trong và bên ngoài. Việc lựa chọn đối tác phù hợp giúp giảm rủi ro kỹ thuật và tài chính, đồng thời cho phép bạn lập kế hoạch và có thể bắt đầu tận dụng những lợi ích lâu dài này sớm trong quá trình di chuyển.

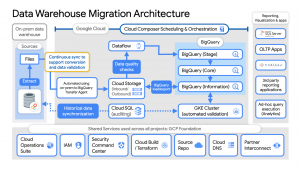

Các ví dụ về kiến trúc di chuyển kho dữ liệu

- Thiết lập các yếu tố nền tảng. Trong GCP bao gồm, IAM để ủy quyền và truy cập, đám mây phân cấp tài nguyên, thanh toán, mạng, code pipelines, Cơ sở hạ tầng dưới dạng code sử dụng Cloud Build với Terraform ( GCP Foundation Toolkit), Cloud DNS và một Liên kết dành riêng đối tác để kết nối với các trung tâm dữ liệu hiện tại.

- Kích hoạt các dịch vụ giám sát và quét bảo mật trước khi dữ liệu người dùng thực được tải bằng Cloud Operations để giám sát và ghi nhật ký và Security Command Center để giám sát bảo mật.

- Trích xuất các tệp từ EDW kế thừa on premise và chuyển sang Cloud Storage và thiết lập đồng bộ hóa đang diễn ra bằng cách sử dụng BigQuery Transfer Services

- Từ Cloud Storage, xử lý dữ liệu trong Dataflow và Tải / xuất dữ liệu sang BigQuery.

- Xác thực việc xuất bằng các tiện ích xác thực của Datametica chạy trong một cụm GKE và Cloud SQL để kiểm tra và đồng bộ hóa dữ liệu lịch sử khi cần. Các nhóm ứng dụng kiểm tra các tập dữ liệu đã được xác thực trong suốt quá trình di chuyển.

- Sắp xếp toàn bộ quy trình bằng cách sử dụng Cloud Composer, được tích hợp với các dịch vụ lập lịch tại chỗ khi cần thiết để tận dụng các quy trình đã thiết lập và giữ cho các hệ thống cũ và mới được đồng bộ hóa.

- Duy trì sự phối hợp chặt chẽ với các nhóm / dịch vụ nhập dữ liệu mới vào EDW và các nhóm phân tích luồng xuống dựa vào dữ liệu EDW cho các phân tích nâng cao đang diễn ra.

- Thiết lập các kiểm soát truy cập chi tiết cho các tập dữ liệu và bắt đầu cung cấp dữ liệu trong BigQuery cho các công cụ báo cáo, trực quan hóa và sử dụng ứng dụng hiện có bằng cách sử dụng trình kết nối dữ liệu BigQuery để người dùng truy cập và thử nghiệm ‘down-stream’.

- Tăng dần khả năng xử lý tốc độ cố định của Big Query để cung cấp việc sử dụng tài nguyên hiệu quả nhất về chi phí trong quá trình di chuyển.

Tìm hiểu thêm về cách di chuyển từ Kho dữ liệu doanh nghiệp on premises (EDW) sang Bigquery và GCP tại đây: https://cloud.google.com/architecture/dw2bq/dw-bq-migration-overview

Nguồn: gcloudvn.com